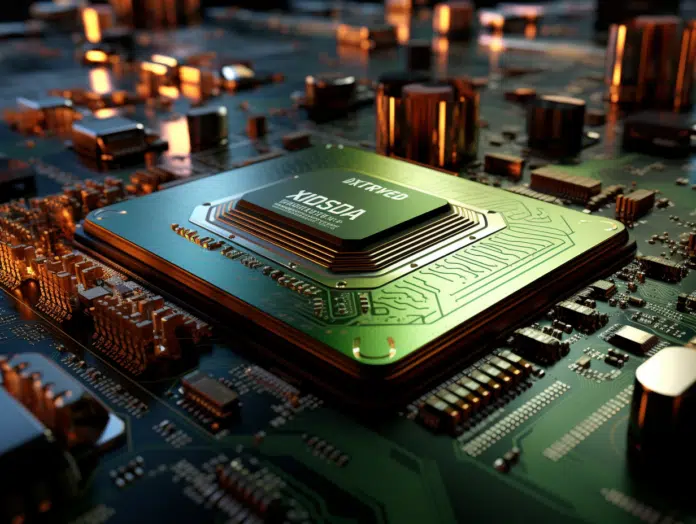

L’architecture des GPU NVIDIA a révolutionné le domaine du traitement parallèle, notamment avec l’introduction des cœurs CUDA. Ces composants sont le moteur de calcul des cartes graphiques de NVIDIA, permettant d’exécuter des opérations complexes à grande vitesse. Ils jouent un rôle clé dans des applications allant du gaming à l’intelligence artificielle. Leur capacité à traiter simultanément de multiples instructions a ouvert la voie à des avancées significatives dans le traitement de données volumineuses et le développement de modèles de machine learning plus sophistiqués. Comprendre leur fonctionnement et leurs avantages est essentiel pour saisir les progrès actuels en informatique.

Plan de l'article

Les fondements des cœurs CUDA de NVIDIA

Initiés avec la série GeForce 8, les cœurs CUDA, pour Compute Unified Device Architecture, constituent l’épine dorsale des GPU de NVIDIA. Cette technologie, développée par l’entreprise elle-même, repose sur un modèle de programmation parallèle qui permet aux développeurs de tirer parti des capacités de calcul des unités de traitement graphique (GPU). La synergie entre le matériel et le logiciel se manifeste par un pilote informatique unifié, capable de diriger les tâches de calcul vers les cœurs CUDA avec une efficacité notable.

A lire en complément : Quel est l'iPhone le plus fiable ?

Abordez le kit de développement de CUDA, et vous touchez à la boîte de Pandore de l’optimisation de performance. Publié le 15 février 2007, ce kit a permis aux programmeurs d’exploiter pleinement le potentiel des GPU pour des opérations autres que le rendu graphique, une pratique connue sous le nom de GPGPU (General-Purpose Computing on Graphics Processing Units). Ce premier pas a marqué le début d’une ère où le calcul intensif devient accessible non seulement aux chercheurs mais aussi aux développeurs de jeux et d’applications.

Le concept Unified Device Architecture est fondamental. Il désigne l’unification de l’architecture de calcul, qui permet aux cœurs CUDA de traiter aussi bien des graphiques que des algorithmes de calcul scientifique. Cette polyvalence transforme les GPU en processeurs multi-usages, aptes à gérer une variété de tâches parallélisables avec une rapidité et une efficacité remarquables.

Lire également : Quel ordinateur portable acheter en 2022 ?

Considérez le paysage technologique actuel : les cœurs CUDA de NVIDIA se distinguent comme des piliers incontournables du calcul parallèle. Leur impact sur l’industrie est palpable, avec des applications qui s’étendent au-delà du cadre traditionnel du rendu graphique pour se nicher au cœur de l’intelligence artificielle, du deep learning et de l’analyse de données massives. Ces cœurs sont le symbole d’une évolution technologique qui n’a de cesse de redéfinir les frontières de l’informatique.

L’impact des cœurs CUDA sur la performance graphique et le calcul parallèle

Dans l’univers des GPU, les cœurs CUDA de NVIDIA se démarquent par leur influence sur la performance graphique. Ces unités de calcul spécialisées travaillent en cohorte pour exécuter les threads qui composent une tâche. Dans l’approche GPGPU, cette capacité se traduit par une accélération notable des processus de rendu, permettant des visuels plus riches et plus fluides. Suivez le fil de cette technologie, et vous découvrirez une réactivité graphique accrue, essentielle dans les domaines du gaming et de la simulation professionnelle.

Le calcul parallèle, quant à lui, bénéficie grandement de l’architecture SIMD (Single Instruction, Multiple Data) qui régit les cœurs CUDA. Cette conception permet à un seul cœur d’exécuter simultanément une instruction sur de multiples données, un avantage conséquent pour les opérations susceptibles d’être parallélisées. Les développeurs exploitent cette capacité pour des applications allant du calcul scientifique au deep learning, où la manipulation simultanée de grands ensembles de données est fondamentale.

La notion de threads warp mérite une attention particulière. Un warp, dans le contexte CUDA, est un ensemble de 32 threads qui sont exécutés en parallèle sur un seul cœur CUDA. Cette finesse dans la gestion des threads améliore l’efficacité du calcul parallèle, permettant ainsi aux GPU de NVIDIA de traiter des volumes massifs de données avec une précision et une vitesse supérieures. Les warps optimisent l’utilisation des ressources du GPU, réduisant les temps d’inactivité et accélérant le traitement global des données.

Comparaison technique : cœurs CUDA contre autres architectures de GPU

Considérez l’architecture GPU NVIDIA, axée sur les cœurs CUDA, comme un élément distinctif dans le paysage concurrentiel des processeurs graphiques. Ces cœurs, spécifiques à la marque, se comparent aux processeurs de flux chez AMD, l’autre géant du secteur. La différence réside dans l’approche de la parallélisation des tâches et la gestion des instructions au sein des unités de calcul. Tandis que les cœurs CUDA privilégient une exécution homogène et synchronisée, les unités AMD optent pour une flexibilité qui peut s’avérer bénéfique dans certaines applications.

Examinez les évolutions successives des architectures NVIDIA, et vous assisterez à une véritable course à l’innovation. De l’architecture Tesla à l’architecture Pascal, chaque génération apporte son lot d’optimisations et de fonctionnalités. L’architecture Tesla, bâtie sur CUDA, a posé les jalons de ce que serait le calcul parallèle moderne. Pascal, en revanche, a poussé les limites de l’efficacité énergétique et de la rapidité de calcul, consolidant la position de NVIDIA dans les hautes performances.

La mise au rebut de l’architecture Fermi, jugée obsolète, illustre la vitesse à laquelle le progrès technologique peut reléguer au second plan des technologies autrefois prédominantes. Cet abandon, au profit du support des architectures plus récentes, souligne la nécessité pour les professionnels et les passionnés de rester à l’affût des mises à jour pour exploiter pleinement les capacités offertes par CUDA.

Abordez la concurrence et vous découvrirez que les cœurs CUDA ne sont pas sans rivaux. Leur principale compétition vient des GPU AMD, avec une architecture qui favorise un plus grand nombre de cœurs, lesquels peuvent exécuter des tâches de manières plus indépendantes les unes des autres. Cette configuration peut se traduire par des avantages dans des scénarios de charge de travail spécifiques, où la diversité des tâches requiert une plus grande indépendance entre les unités de calcul.

Applications pratiques et avenir des cœurs CUDA dans l’industrie

Les cœurs CUDA de NVIDIA ont révolutionné les applications pratiques dans des domaines exigeant une intense puissance de calcul. Le deep learning et l’intelligence artificielle bénéficient considérablement de cette architecture, permettant de traiter de vastes ensembles de données avec une efficacité sans précédent. Les chercheurs et les développeurs exploitent les cœurs CUDA pour accélérer les algorithmes d’apprentissage automatique, réduisant ainsi les temps de calcul de semaines à seulement quelques heures.

Grâce aux langages de programmation tels que C++ et Go, les développeurs tirent parti de l’architecture CUDA pour optimiser les performances des applications nécessitant des calculs parallèles. NVIDIA offre par ailleurs un large éventail de ressources, dont le site web CUDA et un kit de développement gratuiciel, facilitant l’accès à cette technologie pour une communauté grandissante de programmeurs.

La polyvalence de CUDA s’étend aux principaux systèmes d’exploitation, y compris Microsoft Windows, Linux et macOS, garantissant une intégration transparente dans différents environnements informatiques. Cette compatibilité élargit le champ des possibilités pour les entreprises et les développeurs individuels, leur permettant de déployer des solutions basées sur les cœurs CUDA sur une multitude de plateformes.

L’avenir des cœurs CUDA semble prometteur, avec des avancées continues annoncées par NVIDIA. Les mises à jour régulières du CUDA Programming Guide et le lancement de nouvelles générations de GPU sont le gage d’une amélioration constante des capacités de calcul parallèle. Ces évolutions présagent d’un impact croissant sur l’industrie, où la vitesse et l’efficacité de traitement des données deviennent des atouts compétitifs incontestables.